本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.ldbm.cn/p/243440.html

如若内容造成侵权/违法违规/事实不符,请联系编程新知网进行投诉反馈email:809451989@qq.com,一经查实,立即删除!相关文章

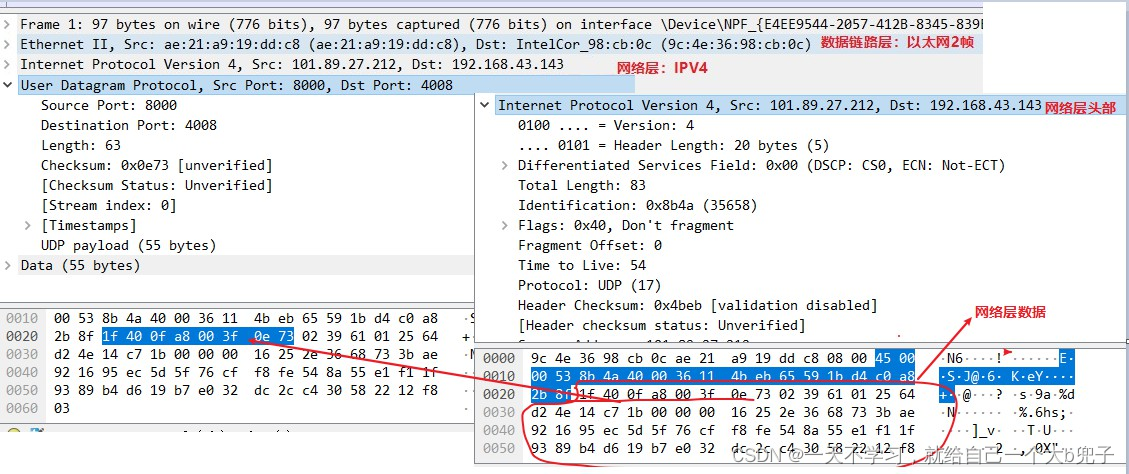

网络知识学习(笔记二)

ios模型规定的网络模型一共有7层,但是实际使用过程中,4层的TCP/IP模型是经常使用的,网络知识学习笔记里面也是基于4层TCP/IP模型进行分析的,前面已经讲了:(1)物理层,(2&a…

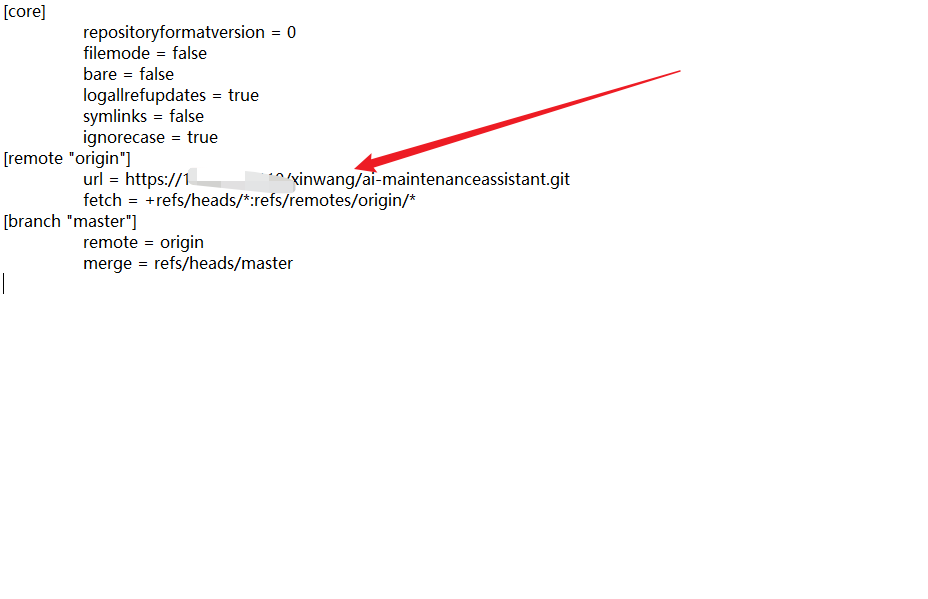

git 更换远程仓库地址三种方法总结分享

因为公司更改了 gitlab 的网段地址,发现全部项目都需要重新更改远程仓库的地址了,所以做了个记录,说不定以后还会用到呢。 一、不删除远程仓库修改(最方便)

# 查看远端地址

git remote -v

# 查看远端仓库名

git rem…

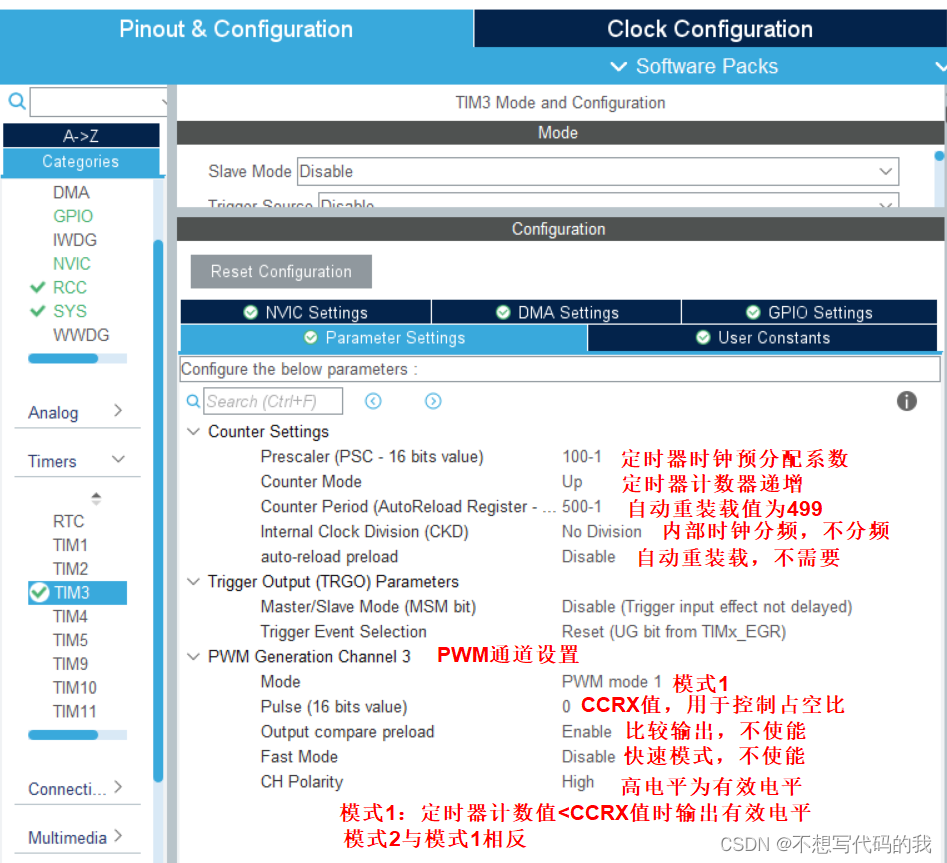

STM32通用定时器产生PWM信号

STM32通用定时器产生PWM信号 PWM信号stm32定时器PWM生成模式PWM配置基本步骤PWM周期计算CubeMX配置代码展现 本期内容我将展示使用STM32通用定时器产生PWM信号,这里以定时器3通道3为例 PWM信号 如果还不懂的话,可以看看 : “蓝桥杯单片机学习…

vite项目配置vite.config.ts在打包过程中去除日志

在生产环境上,务必要将日志清除干净,其因有二,在webgis系统中,有很多几何数据,体积大、数量多,很容易引起系统卡顿;清除log后,系统看着舒服,协同开发有很多无聊的日志&am…

PHP 正则式 全能匹配URL(UBB)

PHP 正则式 全能匹配URL(UBB)

语言:PHP

注明:正则式 无语言限制(js、PHP、JSP、ASP、VB、.net、C#...)一切皆可。

简介:PHP UBB 正则式 全能匹配URL 自动加超级链接。网上找了很多都不匹配或…

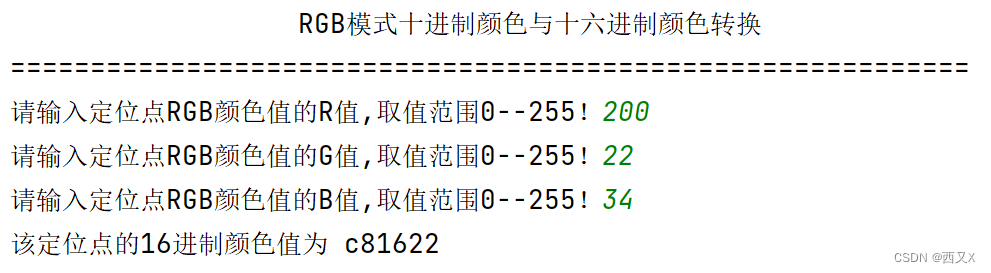

python实战—核心基础3(RGB模式颜色转换器) lv1

目录 一、核心代码解释

二、代码

三、运行截图 一、核心代码解释

1、hex() 函数

参数说明:

x -- 10进制整数

返回值:

返回16进制数,以字符串形式表示。

实例:

以下实例展示了 hex 的使用方法:

>>>h…

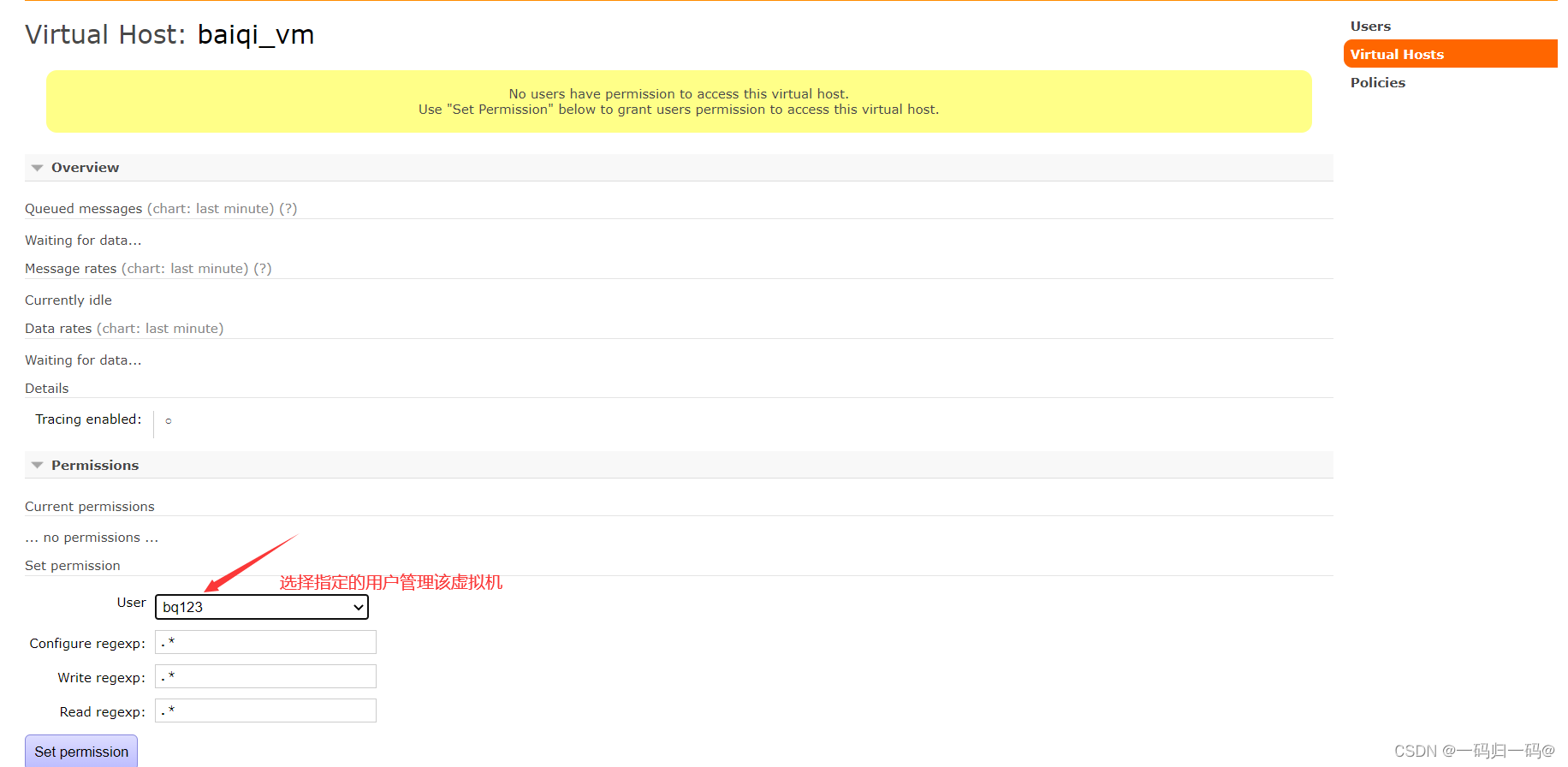

RabbitMQ安装说明

注意: 本次安装以 CentOS 7为例

1、 准备软件 erlang 18.3 1.el7.centos.x86_64.rpm socat 1.7.3.2 5.el7.lux.x86_64.rpm rabbitmq server 3.6.5 1.noarch.rpm 2、安装Erlang rpm -ivh erlang-18.3-1.el7.centos.x86_64.rpm 3.、安装RabbitMQ

安装

rpm -ivh socat-1.7.3.2-…

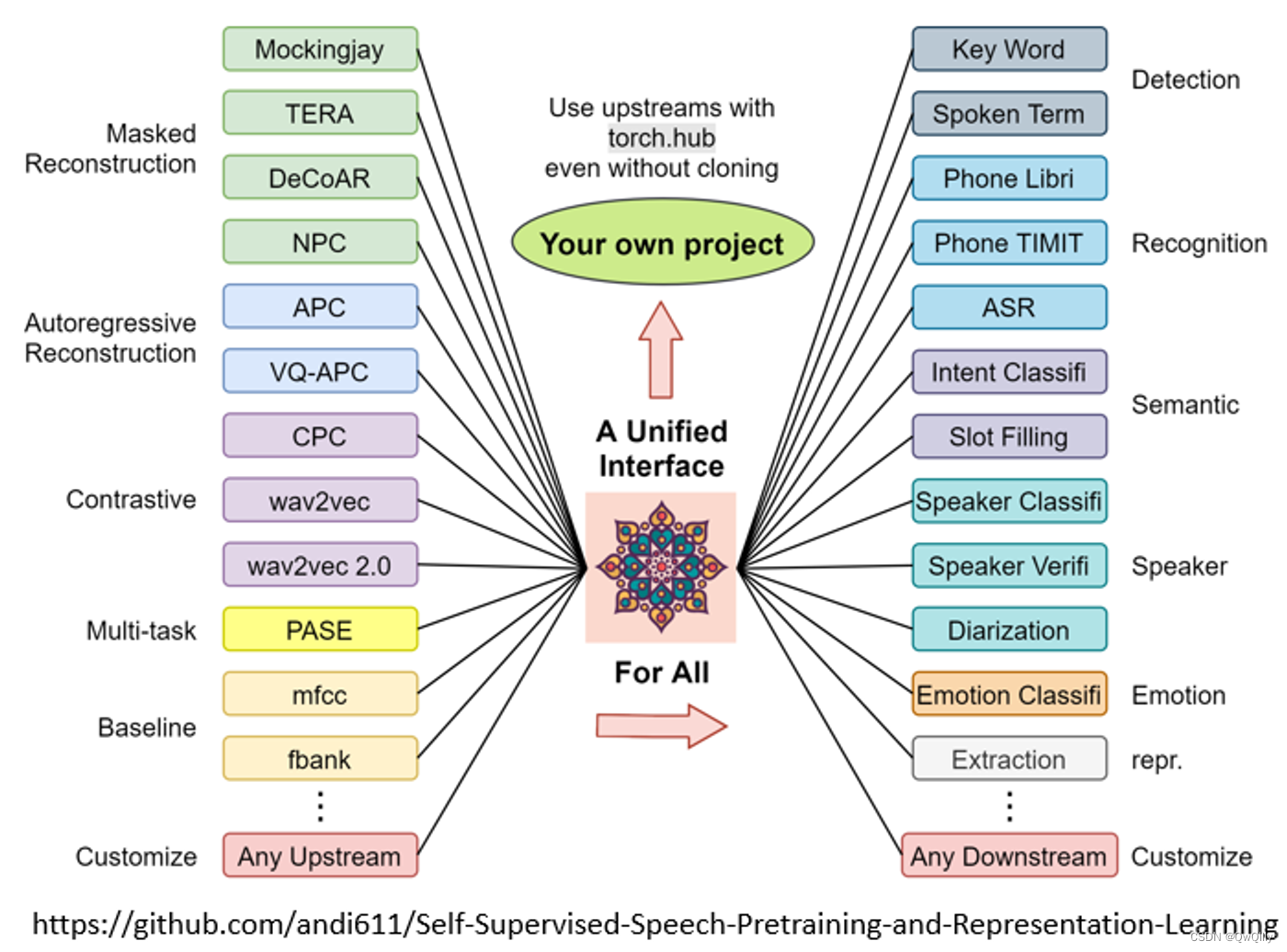

2022最新版-李宏毅机器学习深度学习课程-P49 GPT的野望

GPT→类似于Transformer Encoder

训练任务:Predict Next Token

使用MASK-attention,不断预测“下一个token”。 可以用GPT生成文章。 How to use GPT?

给出描述和例子 给出前半段,补上后半段

In-context Learning(no GD) 结果 目前看起…

[数据结构]-AVL树

前言 作者:小蜗牛向前冲 名言:我可以接受失败,但我不能接受放弃 如果觉的博主的文章还不错的话,还请点赞,收藏,关注👀支持博主。如果发现有问题的地方欢迎❀大家在评论区指正 目录

一、AVL树基…

Unity中颜色空间Gamma与Linear

文章目录 前言一、人眼对光照的自适应1、光照强度与人眼所见的关系2、巧合的是,早期的电子脉冲显示屏也符合这条曲线3、这两条曲线都巧合的符合 y x^2.2^(Gamma2.2空间) 二、Gamma矫正1、没矫正前,人眼看电子脉冲显示屏ÿ…

0时区格林威治时间转换手机当地时间-Android

假设传入的是2023-11-01T12:59:10.420987这样的格式

要将格式为2023-11-01T12:59:10.420987的UTC时间字符串转换为Android设备本地时间,您可以使用java.time包中的类(在API 26及以上版本中可用)。如果您的应用需要支持较低版本的Android&…

Vue弹窗的使用与传值

使用element-UI中的Dialog 对话框 vue组件结合实现~~~~

定义html

<div click"MyAnalyze()">我的区划</div><el-dialog title"" :visible.sync"dialogBiomeVisible"><NationalBiome :closeValue"TypeBiome" cl…

聊聊鼎叔的新书《无测试组织-测试团队的敏捷转型》

这是鼎叔的第八十篇原创文章。行业大牛和刚毕业的小白,都可以进来聊聊。

欢迎关注本公众号《敏捷测试转型》,星标收藏,大量原创思考文章陆续推出。 本书官方购买链接请点击 https://item.jd.com/14105386.html。 为何写作本书 对于“无测试组…

Talk | UCSB博士生宋珍巧:基于人工智能的功能性蛋白质设计

本期为TechBeat人工智能社区第549期线上Talk。 北京时间11月22日(周三)20:00,UC Santa Barbara博士生—宋珍巧的Talk已准时在TechBeat人工智能社区开播! 她与大家分享的主题是: “基于人工智能的功能性蛋白质设计”,介绍了如何利用机器学习算…

React结合antd5实现整个表格编辑

通过react hooks 结合antd的table实现整个表格新增编辑。

引入组件依赖

import React, { useState } from react;

import { Table, InputNumber, Button, Space, Input } from antd;定义数据

const originData [{ key: 1, name: 白银会员, value: 0, equity: 0, reward: 0…

Postgres 数据库中 ULID 和 UUID 的性能

大家好!在本文中,我想分享我对经常用作标识符的数据类型的知识和看法。今天我们将同时讨论两个主题。这些是数据库端按键和键的数据类型衡量的搜索速度。

我将使用PostgreSQL数据库和演示Java服务来比较查询速度。

UUID 和 ULID

为什么我们需要某种难…

酷开科技 | 大胆解锁酷开系统,收获绝佳观影体验

在当今数字化时代,家庭娱乐的方式越来越多样化。其中,看电影无疑是很受欢迎的一种。而酷开科技,作为一家专注于智能电视领域的科技公司,其自主研发的智能电视操作系统——酷开系统,就在看电影方面为消费者带来了更精彩…

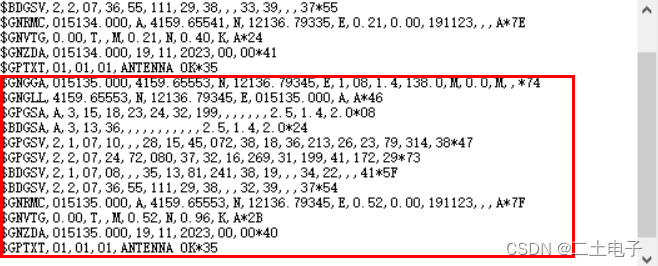

【STM32外设系列】GPS定位模块(ATGM336H)

🎀 文章作者:二土电子 🌸 关注公众号获取更多资料! 🐸 期待大家一起学习交流! 文章目录 一、GPS模块简介二、使用方法2.1 引脚介绍2.2 数据帧介绍2.3 关于不同的启动方式 三、前置知识3.1 strstr函数3.2…

【精选】改进的YOLOv5:红外遥感图像微型目标的高效识别系统

1.研究背景与意义

随着科技的不断发展,红外遥感技术在军事、安防、环境监测等领域中得到了广泛应用。红外遥感图像具有独特的优势,可以在夜间或恶劣天气条件下获取目标信息,因此在小目标检测方面具有重要的应用价值。然而,由于红…

![[数据结构]-AVL树](https://img-blog.csdnimg.cn/98f37a1898c24ce0ae91edba8a3d3a37.png)