本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.ldbm.cn/p/350092.html

如若内容造成侵权/违法违规/事实不符,请联系编程新知网进行投诉反馈email:809451989@qq.com,一经查实,立即删除!相关文章

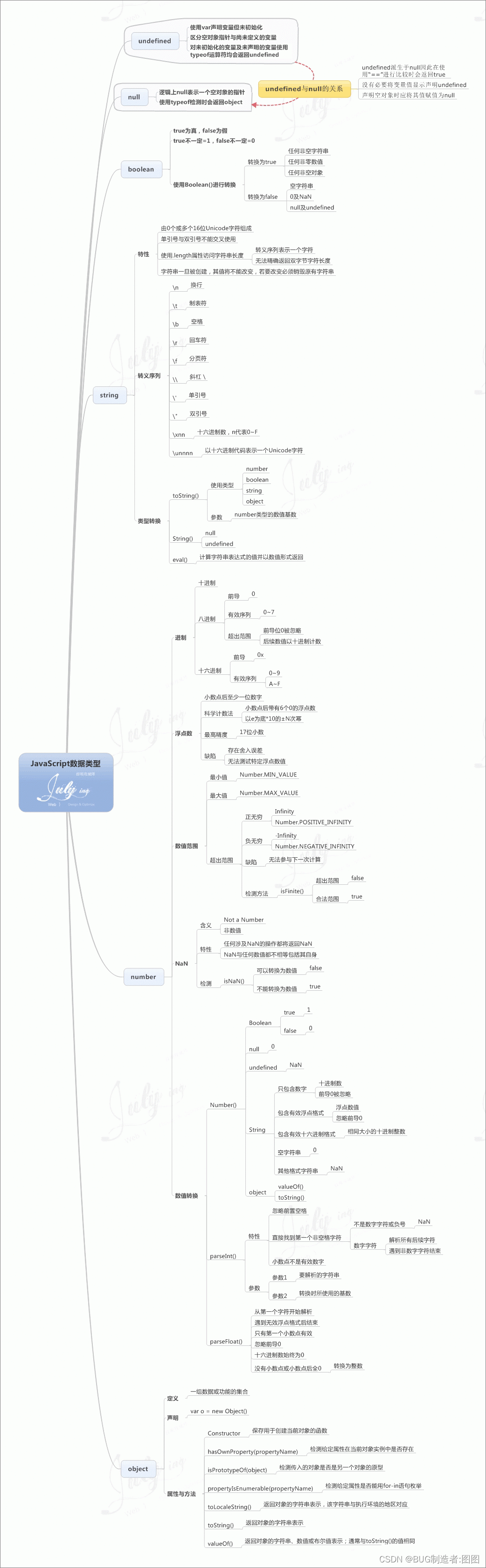

JavaScript数据类型学习脑图

字符串(String)、数字(Number)、布尔(Boolean)、数组(Array)、对象(Object)、空(Null)、未定义(Undefined)

01 Qt自定义风格控件的基本原则

目录

1.继承原生控件

2.组合原生控件

3.仿写原生控件

PS:后续将继续分享开发实践中各类自定义控件的方法、思路以及组件库 1.继承原生控件

关键字:继承、paintEvent 这里想说的是,Qt的Gui框架在封装原生控件的同时, 也为开发者提供了各…

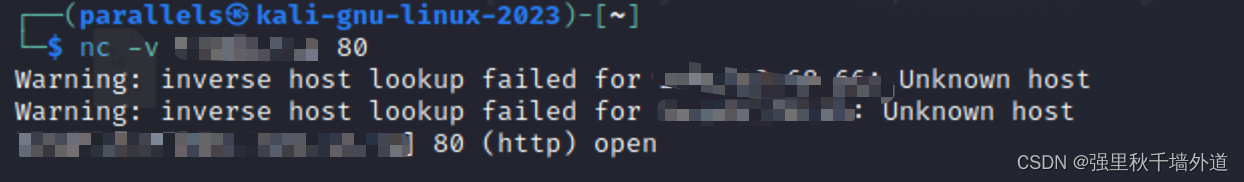

网络安全-nc(Netcat)工具详解

经常在反弹shell的时候使用nc命令,但是从来没有了解过,今天翻书看到了,准备记录一下。

nc全称Netcat,是TCP/IP连接的瑞士军刀。哈哈我最喜欢瑞士军刀了。

有一个比较偏的知识点,nc还可以探测目标的端口是否开放&…

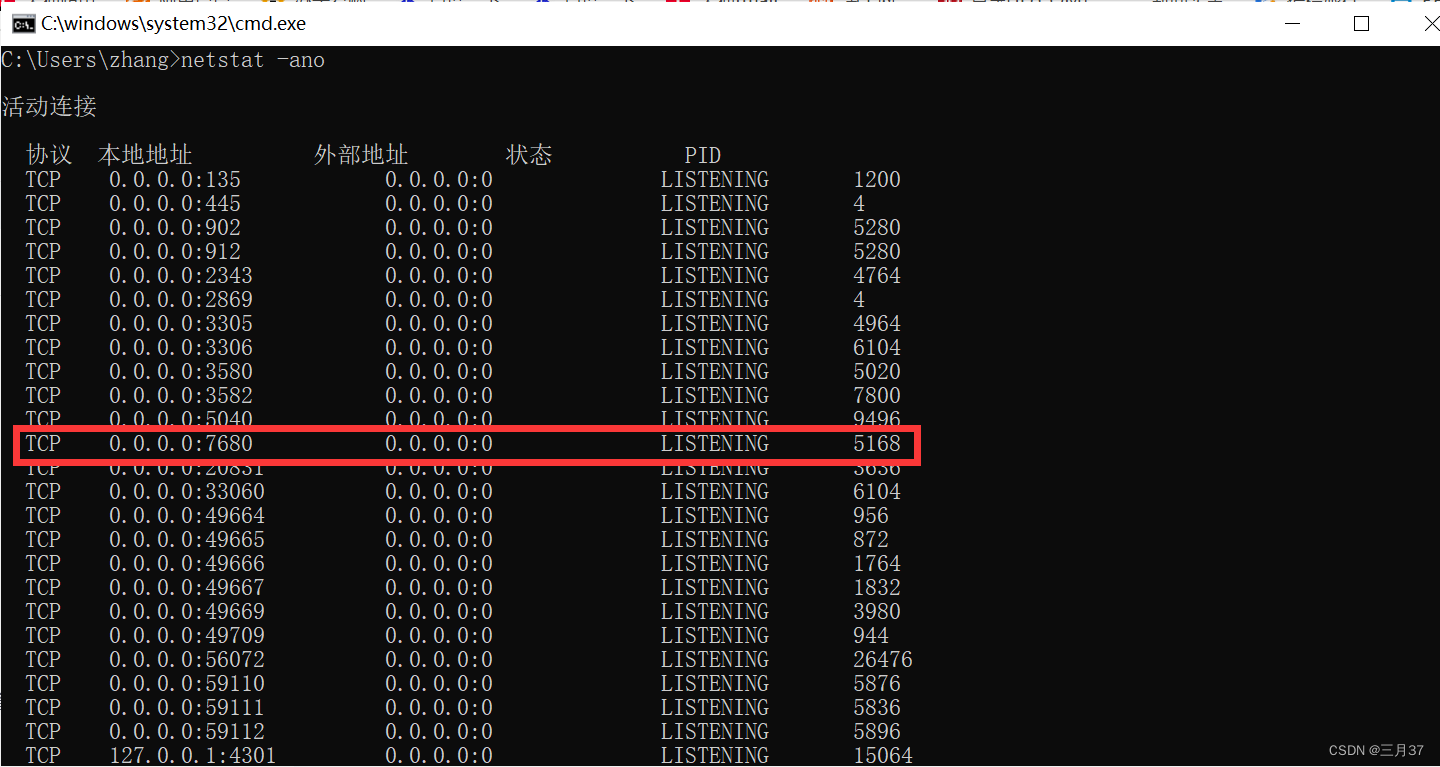

端口号被占用怎么解决

1、快捷键"winR"打开运行,在其中输入"cmd"命令,回车键打开命令提示符。

2、进入窗口后,输入"netstat -ano"命令,可以用来查看所有窗口被占用的情况。

比如端口号为7680的端口被占用了,…

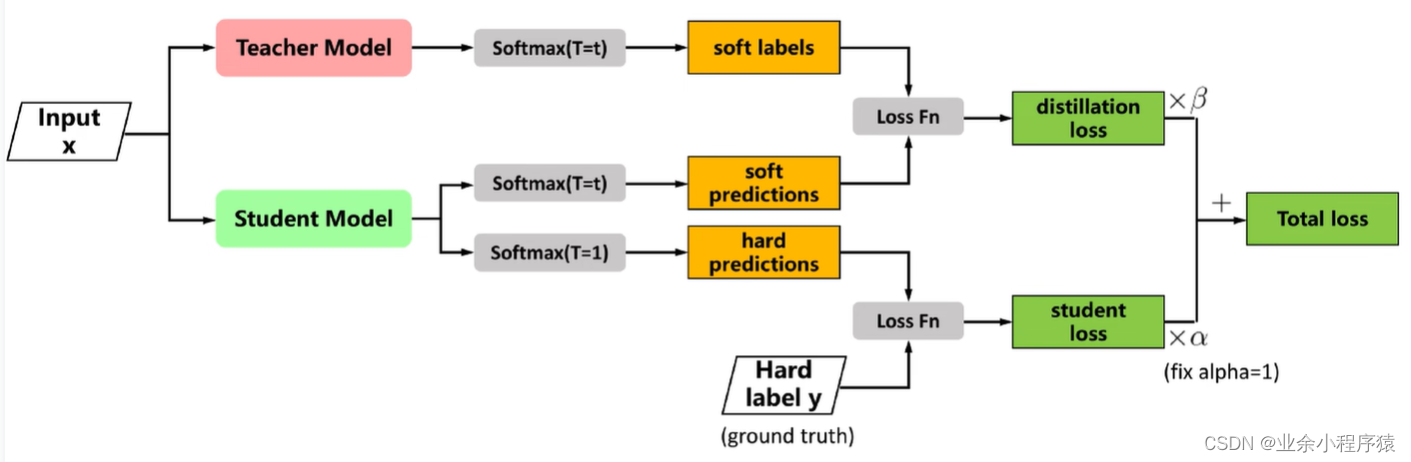

知识蒸馏实战代码教学一(原理部分)

一、知识蒸馏的来源 知识蒸馏(Knowledge Distillation)源自于一篇由Hinton等人于2015年提出的论文《Distilling the Knowledge in a Neural Network》。这个方法旨在将一个大型、复杂的模型的知识(通常称为教师模型)转移到一个小型…

大数据信用报告查询方式一般有几种?哪种比较好?

在了解这个问题之前,想必你对大数据信用与人行信用的区别都是比较清楚了,本文呢就着重讲一下大数据信用报告查询方式有几种,哪种比较好,感兴趣的朋友不妨一起去看看。 大数据信用报告常见的三种查询方式: 一、二维码分…

DAY20 结构和其他数据形式(上)【一万六千字超详细】

文章目录 前言14.1 示例问题:创建图书目录14.2建立结构声明14.3定义结构变量14.3.1 初始化结构14.3.2 访问结构成员14.3.2 结构的初始化器 14.4 结构数组14.4.1 声明结构数组14.4.2 标识结构数组的成员 14.3 嵌套结构14.6 指向结构的指针14.6.1 声明和初始化结构指针…

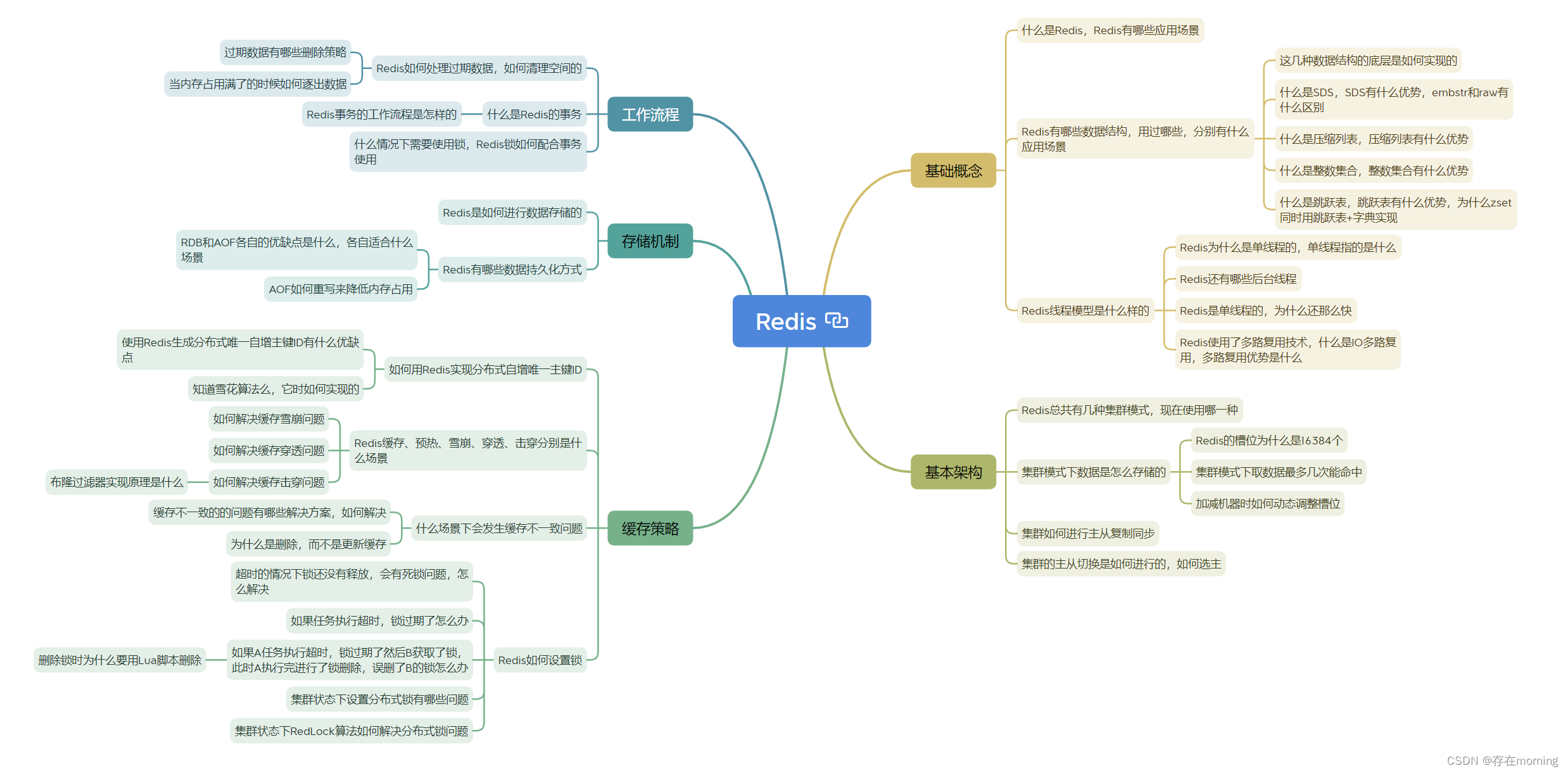

【Java程序员面试专栏 分布式中间件】Redis 核心面试指引

关于Redis部分的核心知识进行一网打尽,包括Redis的基本概念,基本架构,工作流程,存储机制等,通过一篇文章串联面试重点,并且帮助加强日常基础知识的理解,全局思维导图如下所示

基础概念

明确redis的特性、应用场景和数据结构

什么是Redis,Redis有哪些应用场景

Redi…

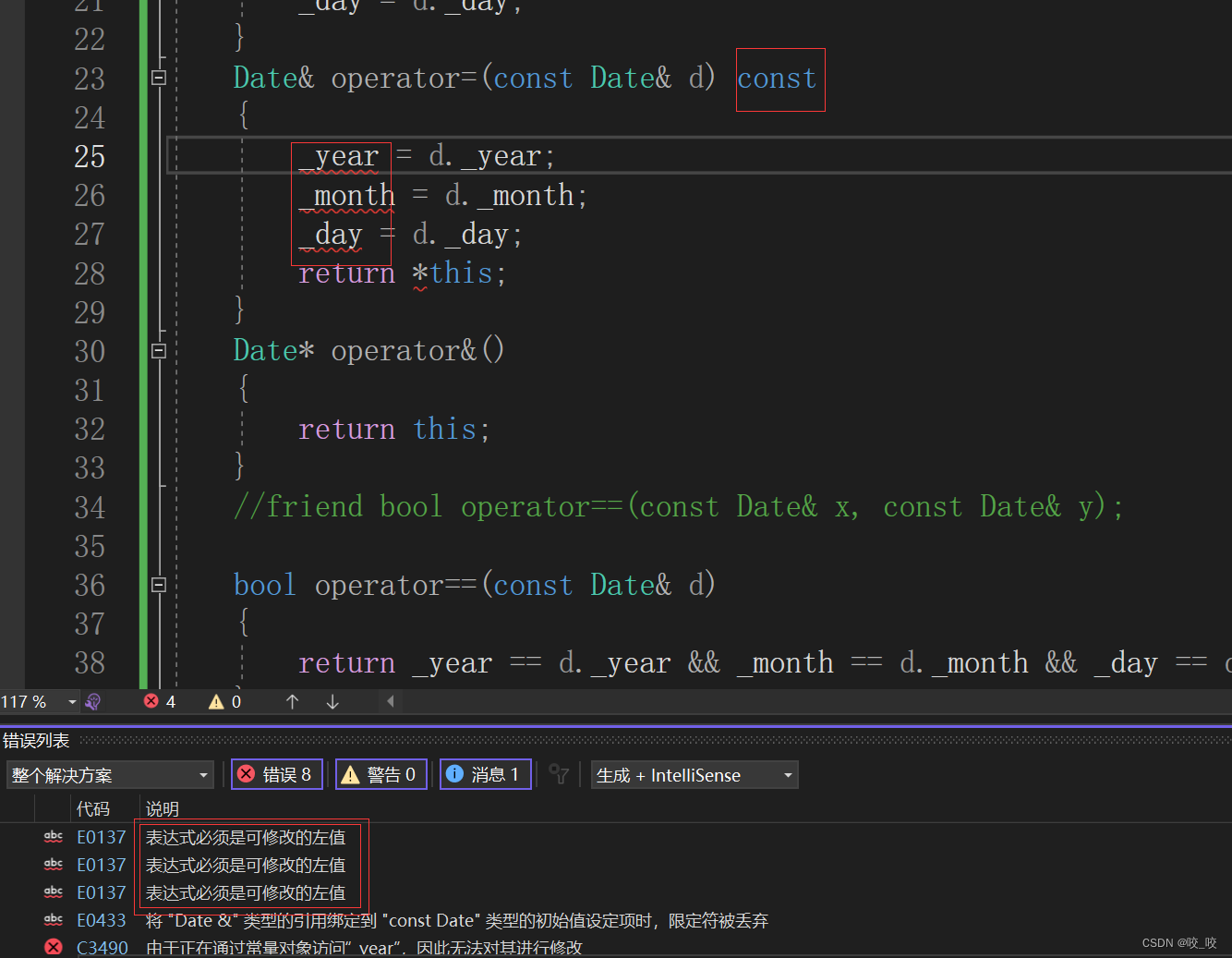

c++类和对象新手保姆级上手教学(中)

前言: 类和对象中篇,这里讲到的前4个默认成员函数,是类和对象中的重难点,许多资料上的讲法都非常抽象,难以理解,所以我作出这篇总结,分享学习经验,以便日后复习。

目录 6个默认成员…

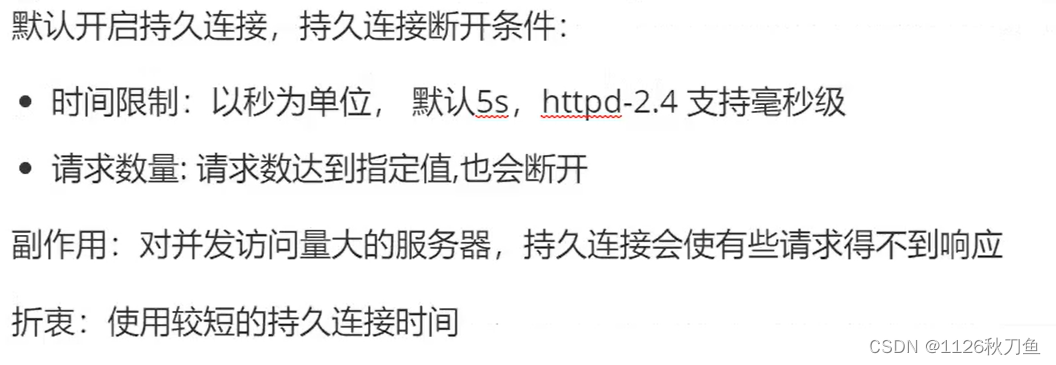

http相关概念以及apache的功能

概念

互联网:是网络的网络,是所有类型网络的母集

因特网:世界上最大的互联网网络

万维网:www (不是网络,而是数据库)是网页与网页之间的跳转关系

URL:万维网使用统一资源定位符,…

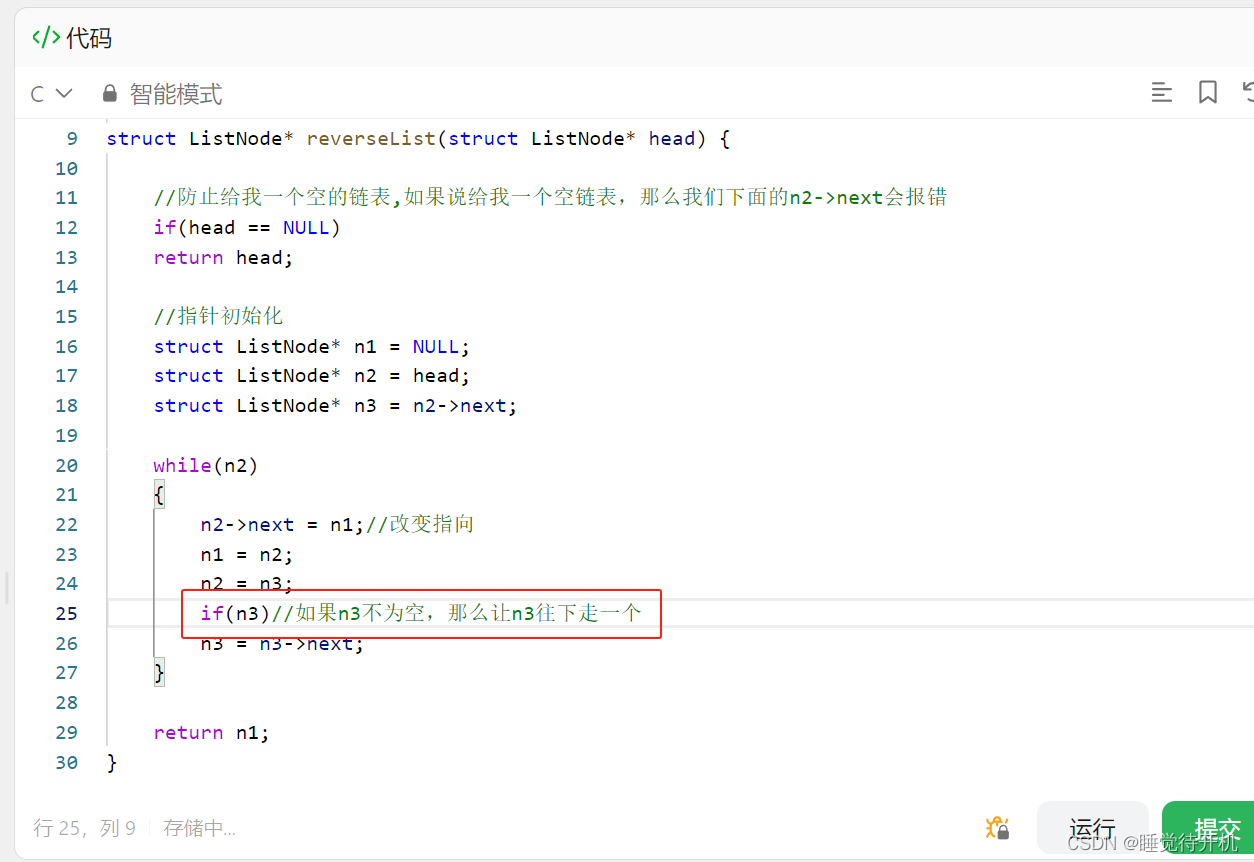

【无标题】力扣报错:member access within null pointer of type ‘struct ListNode‘

项目场景: 做单链表反转题目,报错:member access within null pointer of type ‘struct ListNode’ 题目链接:LINK 问题描述 我明明在初始化指针时候,已经处理了n2->next情况却依然报错 这个报错提示含义是:大概就…

【J1939】一、概述,协议基础

文章目录 1. 背景2. 要点3. J1939帧细节3.1 协议数据单元(Protocol Data Unit,PDU)3.2 参数组编号(PGN)3.3 可疑参数编号(Suspect Parameter Number,SPN)参考1. 背景

J1939是一种用于商用车辆的通信协议,它定义了一套车辆电子控制单元之间进行数据通信的规范。J1939协议…

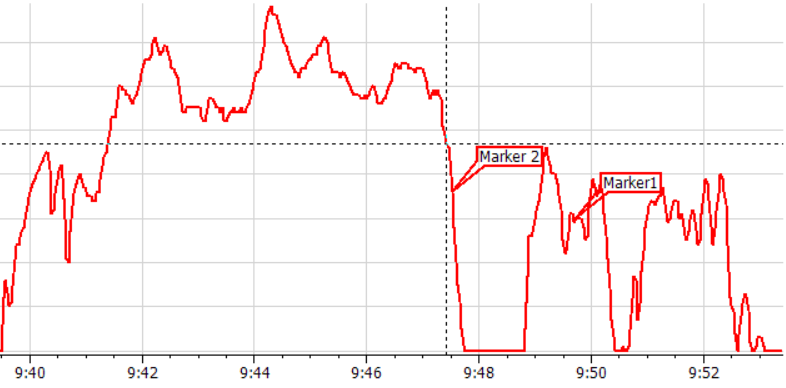

IPEmotion 2023 R2新增视图功能

从IPEmotion 2023 R2开始新增了三个可视化元件,用于在线显示或后处理分析。 一 箱须图

箱须图可用于统计评估。通过该图表,您可快速查看信号的最小值(最下端线条)、最大值(最上端线条)和中位数(…

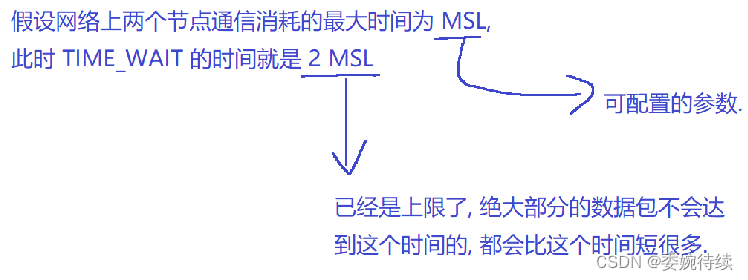

【Java EE初阶十六】网络原理(一)

在网络原理中主要学习TCP/IP四层模型中的重点网络协议

1. 应用层

1.1 应用程序与协议 应用层是和程序员接触最密切的; 应用程序:在应用层这里,很多时候都是程序员自定义应用层协议(步骤:1、根据需求,明确…

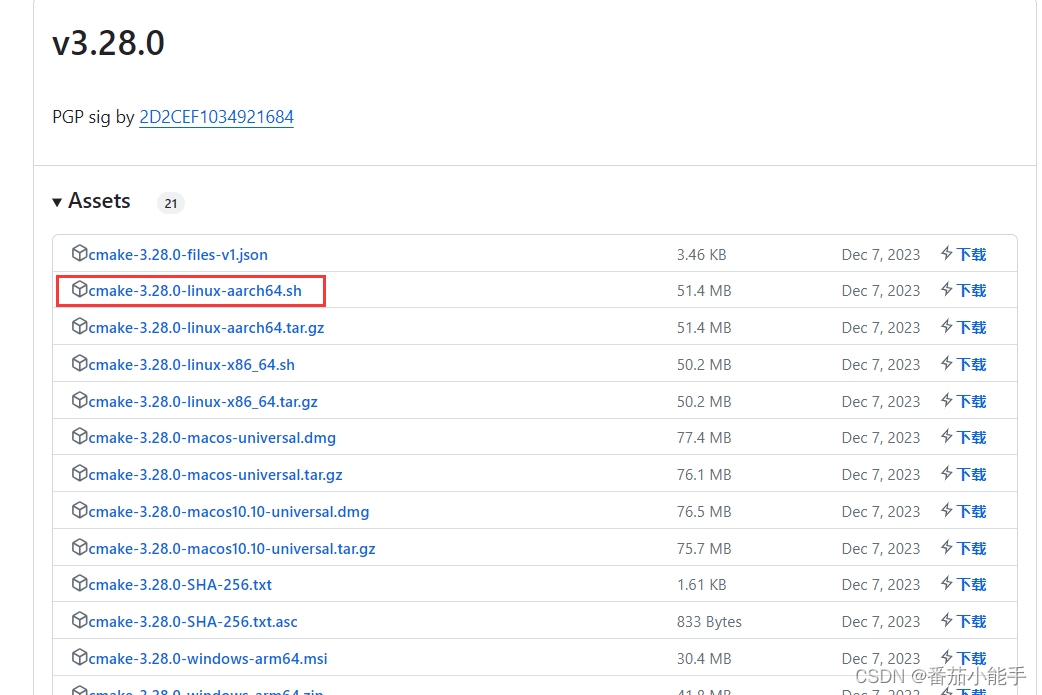

centos7 arm服务器编译安装onnxruntime-gpu

前言 ONNX Runtime是适用于Linux,Windows和Mac上ONNX格式的机器学习模型的高性能推理引擎,但在arm服务器上,onnxruntime只有CPU版的,GPU版的没有,因此需要自行去编译GPU版本的才可以。

环境准备

1、python3.8

2、cmake:2.26.0版本以上,可以直接下载aarch64版本的进行…

YOLOv8改进 | 进阶实战篇 | 利用辅助超推理算法SAHI推理让小目标无所谓遁形(支持视频和图片)

欢迎大家订阅我的专栏一起学习YOLO!

一、本文介绍

本文给大家带来的是进阶实战篇,利用辅助超推理算法SAHI进行推理,同时官方提供的版本中支持视频,我将其进行改造后不仅支持视频同时支持图片的推理方式,SAHI主要的推理场景是针对于小目标检测(检测物体较大的不适用,…

Camera2 createCaptureSession源码分析

当应用调用CameraManager#openCamera获取到已打开的camera设备后,会调用createCaptureSession方法来完成camera stream创建和stream的相关配置。在createCaptureSession方法中,首先将应用的surfaces信息封装成可跨binder传递的OutputConfiguration对象&a…

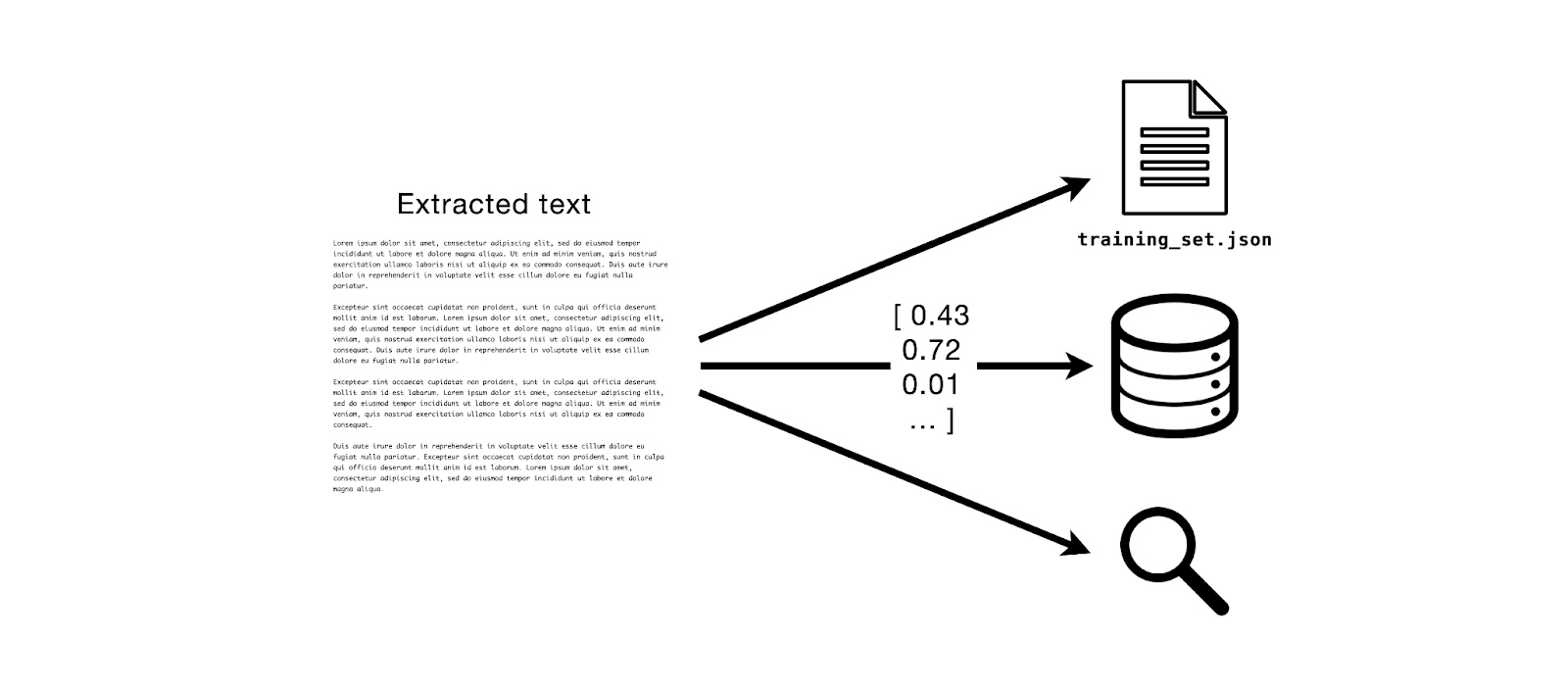

MinIO 和 Apache Tika:文本提取模式

Tl;dr:

在这篇文章中,我们将使用 MinIO Bucket Notifications 和 Apache Tika 进行文档文本提取,这是大型语言模型训练和检索增强生成 LLM和RAG 等关键下游任务的核心。

前提

假设我想构建一个文本数据集,然后我可以用它来微调 LLM.为了做…