本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.ldbm.cn/p/441402.html

如若内容造成侵权/违法违规/事实不符,请联系编程新知网进行投诉反馈email:809451989@qq.com,一经查实,立即删除!相关文章

PDB数据库数据查看和下载

RCSB(Research Collaboratory for Structural Bioinformatics)的PDB(Protein Data Bank)数据库是一个具有全球性影响力的科学数据库,主要用于存储和分享生物大分子(主要是蛋白质、核酸以及部分多糖…

干耳朵里面有坨屎出不来怎么办?口碑好的可视耳勺

干耳朵不比油耳朵,耳道中的耳屎过多会自己流到外耳道出来方便我们清理。干耳朵里面有坨屎出不来建议使用专业的工具来掏,在挖取过程中会更加精准和安全。但随着可视挖耳勺近几年越来越火爆,各种款式层出不穷,这其中也隐藏了不少劣…

[数据集][目标检测]汽车头部尾部检测数据集VOC+YOLO格式5319张3类别

数据集制作单位:未来自主研究中心(FIRC) 版权单位:未来自主研究中心(FIRC) 版权声明:数据集仅仅供个人使用,不得在未授权情况下挂淘宝、咸鱼等交易网站公开售卖,由此引发的法律责任需自行承担 数据集格式:Pascal VOC格…

构建数字化时代的企业:数据驱动的信息架构战略

信息架构的黄金标准:全球企业转型的权威指南

The Open Group:信息架构领域的权威

全球范围的标准制定者

The Open Group是一家专注于企业架构和技术标准的全球性组织,拥有700多家成员机构,包括世界领先的科技公司、咨询公司和学…

中国书法—孙溟㠭篆刻《消失的心》

中国书法孙溟㠭篆刻作品《消失的心》 从小跟我多年的那颗单纯的心找不到了,那颗遇事激动砰砰跳的心没有了,身上多了一颗不属于我的世俗蒙尘铁打不跳动心,我已修成“正果”。甲辰秋月于寒舍小窗下溟㠭刊。 孙溟㠭篆刻《消失的心》 孙溟㠭…

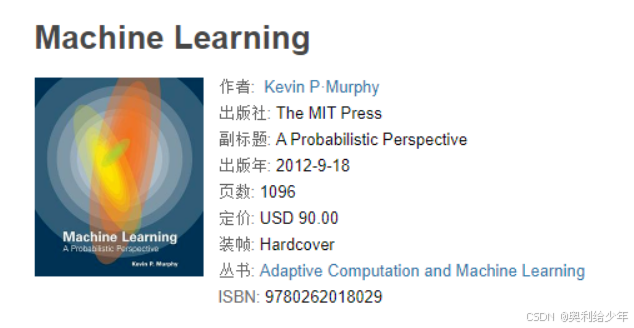

Machine Learning: A Probabilistic Perspective 机器学习:概率视角 PDF免费分享

下载链接在博客最底部!!

之前需要参考这本书,但是大多数博客都是收费才能下载本书。

在网上找了好久才找到免费的资源,浪费了不少时间,在此分享以节约大家的时间。 链接: https://pan.baidu.com/s/1erFsMcVR0A_xT4fx…

C/C++ 网络编程之关于多核利用问题

在 C/C 网络编程之中,多核利用分为以下几类: 1、一个链接一个线程,即传统且淘汰的 MTA 架构 形式:每次捕获链接,create_new_thread 一个子线程出来处理。 优点:开发简单,维护简单。 缺点&#x…

如何通过食堂采购小程序端降低成本,提升效率?

随着数字化管理工具的普及,越来越多的食堂正在引入小程序来优化采购流程,减少成本和提升效率。食堂采购小程序端通过技术手段实现了自动化、智能化的管理方式,为管理者提供了极大的便利。本文将探讨如何利用技术手段开发一个高效的食堂采购小…

C#基础(11)函数重载

前言

前面我们已经完成了ref和out补充知识点的学习,以及函数参数相关的学习,今天便再次为函数补充一个知识点:函数重载。

函数重载是指在同一个作用域中,可以有多个同名函数,但参数列表不同。它的发展可以追溯到早期…

vue + Element UI table动态合并单元格

一、功能需求 1、根据名称相同的合并工作阶段和主要任务合并这两列,但主要任务内容一样,但要考虑主要任务一样,但工作阶段不一样的情况。(枞向合并) 2、落实情况里的定量内容和定性内容值一样则合并。(横向…

请解释JSP中的九大内置对象及其作用。什么是Java Web中的请求转发和重定向?它们有什么区别?

请解释JSP中的九大内置对象及其作用。

JSP(JavaServer Pages)中的九大内置对象(也称为隐式对象或自动对象)是JSP容器为每个页面提供的Java对象,这些对象在JSP页面被转换成Servlet时自动可用,无需显式声明。…

数学建模:控制预测类——时间序列ARIMA模型

目录

1.时间序列ARIMA模型

2.ARIMA模型大纲

3.模型详解

1)自回归模型AR(p)

2)移动平均模型MA(q)

3)自回归移动平均模型ARMA(p,q)

4)差分自回归移动平均模型ARIMA(p,d,q)

4.ARIMA模型建模步骤

5.建模步骤名词解释

1&…

解决:Vue 中 debugger 不生效

目录 1,问题2,解决2.1,修改 webpack 配置2.2,修改浏览器设置 1,问题

在 Vue 项目中,可以使用 debugger 在浏览器中开启调试。但有时却不生效。

2,解决

2.1,修改 webpack 配置

通…

onpm报错: Install failed

api 9 安装ohos/pulltorefresh2.0.1报错误 ohpm install ohos/pulltorefresh2.0.1

ohpm INFO: fetching meta info of package ohos/pulltorefresh

ohpm WARN: fetch meta info of package ohos/pulltorefresh failed - GET https://registry.npmjs.org/ohos/pulltorefresh 404…

怎么仿同款小程序的开发制作方法介绍

很多老板想要仿小程序系统,就是想要做个和别人界面功能类似的同款小程序系统,咨询瀚林问该怎么开发制作?本次瀚林就为大家介绍一下仿制同款小程序系统的方法。

1、确认功能需求 想要模仿同款小程序系统,那么首先需要找到自己想要…

Qt 学习第十天:标准对话框 页面布局

系统标准对话框

错误对话框

//错误对话框connect(createPro, &QAction::triggered, this, []{//参数1 父亲 参数2 标题 参数3 对话框内显示文本内容 。。。QMessageBox::critical(this, "报错!", "没加头文件!");});

【运行结果】 信息对话框

co…

JDBC API详解二

PreparedStatement

作用: 预编译SQL的执行,,预防SQL注入问题

SQL注入

通过操作输入来修改预先定义好的SQL语句,用以达到执行代码对服务器进行攻击的方法;

SQL注入延时

需求,完成用户登录

select * fr…

nodejs基础教程之-异步编程promise/async/generator

1. 异步

所谓"异步",简单说就是一个任务分成两段,先执行第一段,然后转而执行其他任务,等做好了准备,再回过头执行第二段,比如,有一个任务是读取文件进行处理,异步的执行过程就是下面…

产业互联网新星闪耀,“太行云商”引领传统产业数字化革命

产业互联网新星升起

晋城,作为我国能源及相关产业的重要基地,一直面临着信息协同不畅、存货供需失衡、资金融通困难等诸多挑战。

2023年,为了应对这些难题,晋城市政府携手AMT企源,成立了太行云商科技有限公司&#x…

JAVA实现压缩包解压兼容Windows系统和MacOs

目标:JAVA实现压缩包解压获取图片素材

问题:Windows系统和MacOs压缩出来的zip内容有区别

MacOs会多出来 以及本身一个文件夹 而windows则不会。为了解决这个问题。兼容mac的压缩包增加一层过滤

要知道

ZipInputStream 可以读取 ZIP 文件中的条目&…

![[数据集][目标检测]汽车头部尾部检测数据集VOC+YOLO格式5319张3类别](https://i-blog.csdnimg.cn/direct/338e6cc1459b4ad4bf63d486c8646032.png)