本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.ldbm.cn/p/442584.html

如若内容造成侵权/违法违规/事实不符,请联系编程新知网进行投诉反馈email:809451989@qq.com,一经查实,立即删除!相关文章

Springboot项目打war包运行及错误解决

一,打war包

1. 修改pom.xml

为了不影响原pom.xml, 我复制了一个文件叫pom_war.xml , 需要打war包就采用pom_war.xml进行打war包, 你也可以直接修改pom.xml

① 打包方式改为war

没有就增加此配置

<packaging>war</packaging>

② 排除内嵌tomcat依赖 <de…

IP地址、地址分类、子网掩码、子网划分、使用Python计算子网划分

IP 地址(Internet Protocol Address)乃是用于明确标识网络中各类设备的独一无二的地址。IP 地址主要存在两种重要类型,即 IPv4 和 IPv6 。

IPv4地址

IPv4 地址实则是一个由 32 位二进制数字所构成的标识,通常会以四个十进制数字…

设计师私藏的 PDF 转 JPG 利器

你平常会通过扫描来发送文件吗?为了保证图片的清晰度一般都会采用PDF格式来转发,但是要插入到一些文件里的时候PDF格式不是那么好用。这时候就很需要PDF转jpg工具了。今天我就分享几款我用过的PDF转jpg的工具,有兴趣就接着往下看吧。

1.福昕…

Vue框架;Vue中的选择和循环结构;Vue数据类型;Vue中的事件和动态属性;Vue子组件通过导入在主组件显示在网页;Vue中主组件向子组件传递数据

一,Vue简介 前端现在比较火的三大框架就是:vue ,React,Angular。在国内使用最多的还是: vue >React >Angular Vue (发音为 /vjuː/,类似 view) 是一款用于构建用户界面的 JavaScript 框架。它基于标准…

html+css+js网页设计 旅游 大理旅游7个页面

htmlcssjs网页设计 旅游 大理旅游7个页面

网页作品代码简单,可使用任意HTML辑软件(如:Dreamweaver、HBuilder、Vscode 、Sublime 、Webstorm、Text 、Notepad 等任意html编辑软件进行运行及修改编辑等操作)。

获取源码

1&#…

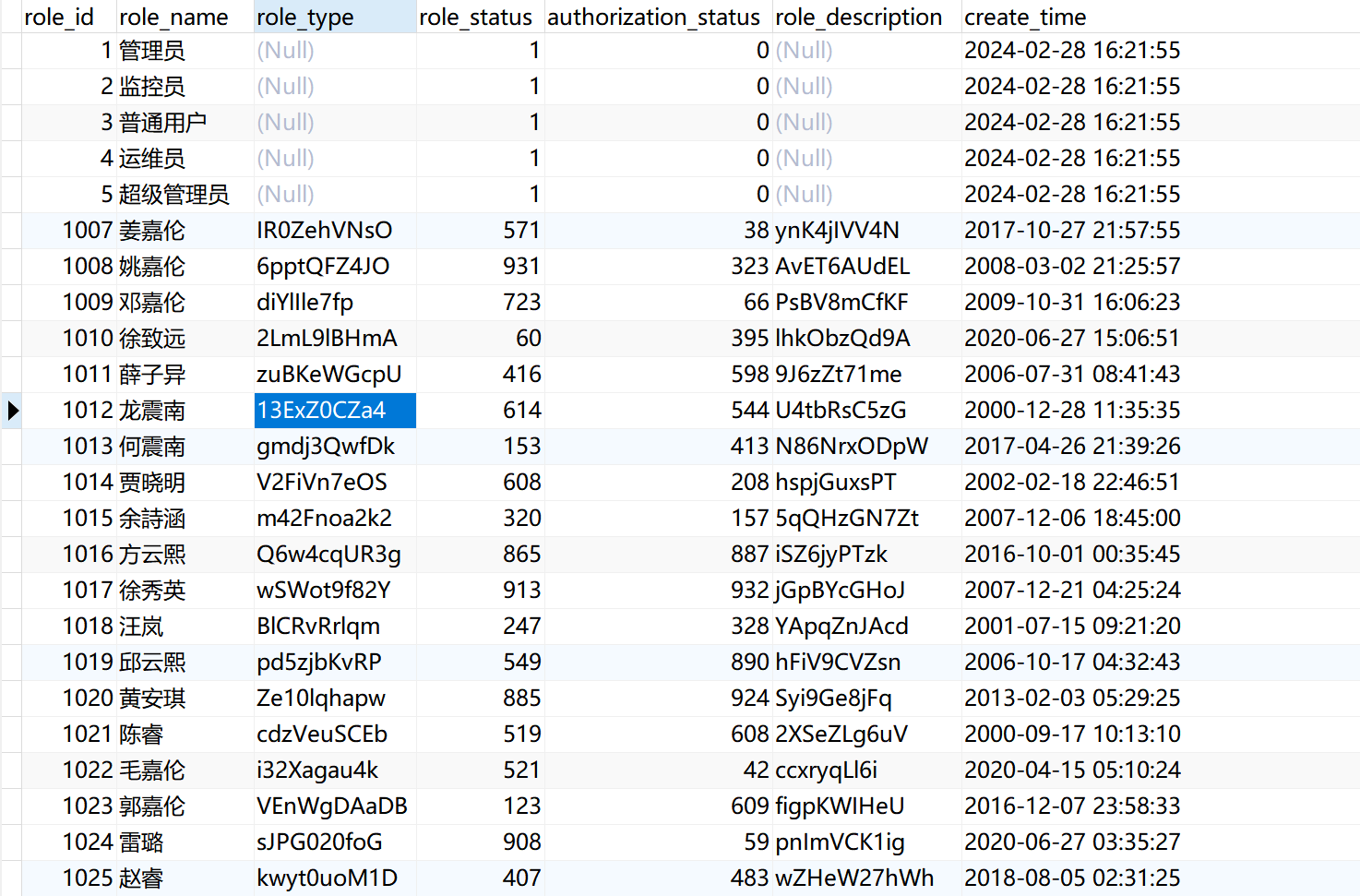

项目需求 | MySQL增量备份与恢复的完整操作指南

目录

一、MySql数据库增量备份的工作原理

1、全量备份与增量备份

2、增量备份原理

二、进行增量备份

步骤1:启用二进制日志

使用 SHOW VARIABLES 命令查看二进制日志状态

步骤2:执行增量备份脚本

三、使用增量备份恢复损坏的数据库

步骤1&#…

uniapp 发布苹果IOS详细流程,包括苹果开发者公司账号申请、IOS证书、.p12证书文件等

记录一下uniapp发布苹果IOS的流程。

一、苹果开发者公司账号申请 1、邓白氏编码申请(先申请公司邓白氏编码,这一步需要1-2周,没有这个编码苹果开发者没法申请,已有编码的跳过此步骤): 1)联系苹…

计算机网络:概述 - 计算机网络概述

目录

一. 互联网概述

1.1 网络

1.2 互联网

1.3 因特网 二. 互联网发展的三个阶段

三. 互联网的标准化工作

四. 互联网的组成

五. 计算机网络的类别

5.1 计算机网络的定义

5.2 计算机网络的不同类别 一. 互联网概述

起源于美国的互联网现如今已…

django-admin自定义功能按钮样式

位置在原来的django-admin 栏中的上方【会因为屏幕大小而变换位置】 <!-- 这里是不会替换掉旧的 添加按钮 ,而是添加多一个按钮【点击Crawl Data】-->

<!-- /home/luichun/lc/Pyfile/Pywebback/app/paqu/templates/admin/yourmodel_changelist.html -->…

江西金融发展集团通过ZStack Zaku容器云推进数字化转型

江西金融发展集团选择ZStack Zaku容器云平台作为其数字化转型的关键技术支撑,以期构建一个创新的金融服务平台,实现业务流程的自动化和智能化,同时推出符合市场需求的新型金融产品。

产融结合综合金融服务集团

江西金融发展集团股份有限公司…

利士策分享,细品礼仪之美:在日常中优雅相处的艺术

利士策分享,细品礼仪之美:在日常中优雅相处的艺术 在当今这个快节奏、高压力的社会里,人与人之间的交往似乎被简化成了快餐式的信息交流。 然而,根植于文化深处的礼仪之花,依然是促进社会和谐、深化人际关系的宝贵财富…

[进阶]面向对象之多态(练习)

需求:

//父类animal

package polymorphism.Test;public abstract class Animal {private int age;private String color;public Animal() {}public Animal(int age, String color) {this.age age;this.color color;}public int getAge() {return age;}public void setAge(i…

MacOS wine中文乱码问题

安装wine

1、brew update 执行失败,提示安装如下

2、git -C /usr/local/Homebrew/Library/Taps/homebrew/homebrew-cask fetch --unshallow

3、git -C /usr/local/Homebrew/Library/Taps/homebrew/homebrew-core fetch --unshallow

3、brew update

4、brew in…

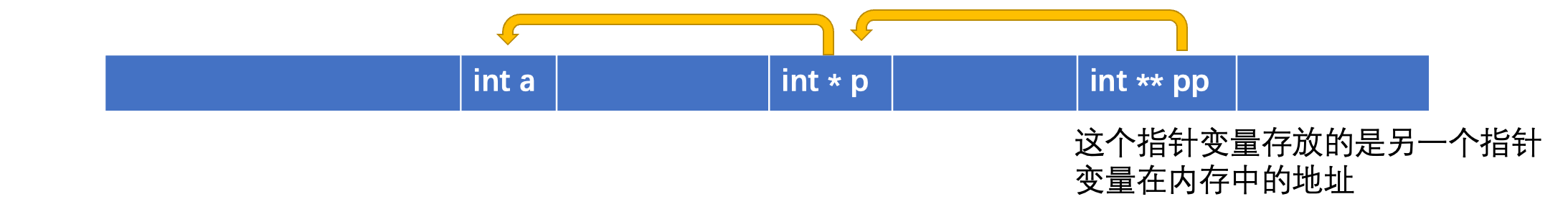

C到C++入门基础知识

一:命名空间:namespace

(一):命名空间的定义

注:命名空间只能定义在全局,不能定义在函数内部。

(1)类似于C语言的结构体,C语言的命名空间定义为࿱…

【论文阅读】视觉分割新SOTA: Segment Anything(SAM)

导言

随着基于对比文本—图像对的预训练(CLIP)方法或者模型、聊天生成预训练转换器(ChatGPT)、生成预训练转换器-4(GPT-4)等基础大模型的出现,通用人工智能( AGI)的研究…

yolo自动化项目实例解析(二)ui页面整理

我们在上一章整理main.py 的if __name__ __main__: 内容还留下面这一段, app QApplication(sys.argv) # 初始化Qt应用ratio screen_width / 2560 # 分辨率比例# 设置全局字体大小# 计算字体大小base_font_size 13# 基准字体大小,适合1920*1080分辨…

Oracle发邮件功能:设置的步骤与注意事项?

Oracle发邮件配置教程?如何实现Oracle发邮件功能?

Oracle数据库作为企业级应用的核心,提供了内置的发邮件功能,使得数据库管理员和开发人员能够通过数据库直接发送邮件。AokSend将详细介绍如何设置Oracle发邮件功能。

Oracle发邮…

![[进阶]面向对象之多态(练习)](https://i-blog.csdnimg.cn/direct/974e59cd97514196a65e43ef5b1939aa.png)