本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处:http://www.ldbm.cn/p/443228.html

如若内容造成侵权/违法违规/事实不符,请联系编程新知网进行投诉反馈email:809451989@qq.com,一经查实,立即删除!相关文章

OpenCV结构分析与形状描述符(21)计算包围给定点集的最小面积三角形函数minEnclosingTriangle()的使用

操作系统:ubuntu22.04 OpenCV版本:OpenCV4.9 IDE:Visual Studio Code 编程语言:C11

算法描述

找到一个包围二维点集的最小面积三角形,并返回其面积。

该函数找到一个包围给定的二维点集的最小面积三角形,并返回其面…

VMware Fusion虚拟机Mac版 安装Win10系统教程

Mac分享吧 文章目录 Win10安装完成,软件打开效果一、VMware安装Windows10虚拟机1️⃣:准备镜像2️⃣:创建虚拟机3️⃣:虚拟机设置4️⃣:安装虚拟机(步骤和Win11安装步骤类似,此处相同步骤处没换…

828华为云征文|基于华为云Flexus云服务器X实现个人博客搭建

文章目录 ❀前言❀部署前准备❀宝塔安装❀安全组开放❀web访问验证❀安装docker❀安装wordpress❀安全组开放18040端口❀访问博客网址❀发布个人博客❀总结 ❀前言

大家好,我是早九晚十二。 近期华为云推出了最新的华为云Flexus云服务器X,这款云主机在算…

Linux实操笔记2 Ubuntu安装Nginx的不同方法

今天来了解Ubuntu或者说Linux系统安装Nginx的几种办法。包括从Ubuntu的库安装到官方源码编译安装。

一、Nginx是什么?

以下是来自Nginx中文文档的内容。 Nginx 是一个高性能的 Web 和反向代理服务器, 它具有有很多非常优越的特性: 作为 Web 服务器:相比…

UML 类图(提供 Java 实现)

文章目录 UML 类图概述及作用类图表示法类(接口)的表示类与类之间关系的表示关联关系(Association)单向关联(Unidirectional Association)双向关联(Bidirectional Association)自关联…

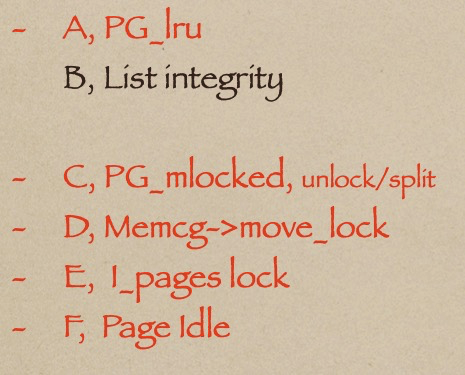

Linux memcg lru lock提升锁性能

内核关于per memcg lru lock的重要提交:

f9b1038ebccad354256cf84749cbc321b5347497

6168d0da2b479ce25a4647de194045de1bdd1f1d

计算虚拟地址转换基本机制

为了处理多应用程序的地址冲突, linux 系统在应用中使用了虚拟地址,得益于硬件的…

linux 操作系统下date 命令介绍和使用案例

linux 操作系统下date 命令介绍和使用案例

在 Linux 操作系统中,date 命令是一个用于显示和设置系统日期和时间的基本工具。它不仅可以显示当前的日期和时间,还允许用户以不同的格式输出日期,并进行日期计算

1. date 命令简介

date 命令用…

TypeScript类

TypeScript 类

TypeScrip 类的出现完全改变了前端领域项目代码编写模式,配合 TypeScript 静态语言,编译期间就能检查语法错误的优势【项目上线后隐藏语法错误的风险几乎为零,相比不用 TypeScript 开发项目,使用 TypeScript 后对前…

MATLAB 从 R2024B 开始支持树莓派 5

树莓派(Raspberry Pi)系列是一系列基于单板计算机的微型电脑,由英国的树莓派基金会于 2012 年开始发布。它的目标是提供一个低成本、易于学习和玩耍的平台,用于教育和初学者学习计算机科学和编程。

目前市面上,最新最…

宿舍管理系统的设计与实现 (含源码+sql+视频导入教程)

👉文末查看项目功能视频演示获取源码sql脚本视频导入教程视频

1 、功能描述 宿舍管理系统拥有三个角色,分别为系统管理员、宿舍管理员以及学生。其功能如下:

管理员:宿舍管理员管理、学生管理、宿舍楼管理、缺勤记录管理、个人密…

Nature Geoscience 最新文章解码自然的气候护盾!植物多样性增强草地土壤温度稳定性

本文首发于“生态学者”微信公众号!

近日,德国综合生物多样性研究中心(iDiv)、莱比锡大学、耶拿弗里德里希席勒大学(FSU)以及其他研究机构的科学家们基于连续18年的草地生物多样性实验揭示了植物多样性能增…

【Android 13源码分析】WindowContainer窗口层级-3-实例分析

在安卓源码的设计中,将将屏幕分为了37层,不同的窗口将在不同的层级中显示。 对这一块的概念以及相关源码做了详细分析,整理出以下几篇。

【Android 13源码分析】WindowContainer窗口层级-1-初识窗口层级树

【Android 13源码分析】WindowCon…

Visual Studio(vs)下载安装C/C++运行环境配置和基本使用注意事项

基本安装

点击跳转到vs官网点击箭头所指的按钮进行下载双击运行刚才下载好的下载器点击继续勾选“使用C的桌面开发”和“Visual Studio扩展开发”点击“安装位置”,对vs的安装位置进行更改。你可以跟我一样只选择D盘或者其他你空闲的盘,然后将默认的路径…

[数据集][目标检测]智慧交通铁路异物入侵检测数据集VOC+YOLO格式802张7类别

数据集格式:Pascal VOC格式YOLO格式(不包含分割路径的txt文件,仅仅包含jpg图片以及对应的VOC格式xml文件和yolo格式txt文件) 图片数量(jpg文件个数):802 标注数量(xml文件个数):802 标注数量(txt文件个数):802 标注类别…

Linux入门攻坚——32、Mini Linux制作

制作一个mini linux,需要对linux的启动流程很熟悉,这里又一次学习Linux的启动过程。

启动流程:CentOS 6 / 5: POST -->BootSequence(BIOS) --> BootLoader --> kernel (ramdisk) --> rootfs --> /sbin/init …

Windows 上下载、编译 OpenCV 并配置系统环境变量的详细步骤

创作不易,您的打赏、关注、点赞、收藏和转发是我坚持下去的动力!

在 Windows 上下载并编译 OpenCV,然后配置系统环境变量的步骤如下:

1. 下载 OpenCV

打开 OpenCV 官方下载页面。找到最新的 Windows 版本,点击下载&…

几种手段mfc140u.dll丢失的解决方法,了解mfc140u.dll

在使用Windows操作系统时,许多用户可能会遇到“找不到mfc140u.dll”或“mfc140u.dll未找到”的错误提示。这个错误通常是由于该文件丢失或损坏所致。本文将详细介绍mfc140u.dll文件的作用、丢失的原因及其解决方法,帮助您快速恢复系统的正常运行。 一、m…

MySQL高可用配置及故障切换

目录

引言

一、MHA简介

1.1 什么是MHA(MasterHigh Availability)

1.2 MHA的组成

1.3 MHA的特点

1.4 MHA工作原理

二、搭建MySQL MHA

2.1 实验思路

2.2 实验环境

1、关闭防火墙和安全增强系统 2、修改三台服务器节点的主机名

2.3 实验搭建

1、…

SOT23封装1A电流LDO具有使能功能的 1A、低 IQ、高精度、低压降稳压器系列TLV757P

前言 SOT23-5封装的外形和丝印 该LDO适合PCB空间较小的场合使用,多数SOT23封装的 LDO输出电流不超过0.5A。建议使用时输入串联二极管1N4001,PCB布局需要考虑散热,参考文末PCB布局。

1 特性

• 采用 SOT-23 (DYD) 封装,具有 60.3C/W RθJA •…

深度学习之线性代数预备知识点

概念定义公式/案例标量(Scalar)一个单独的数值,表示单一的量。例如:5, 3.14, -2向量 (Vector)一维数组,表示具有方向和大小的量。 ,表示三维空间中的向量 模(Magnitude)向量的长度,也称为范数(通常为L2范数…

![[数据集][目标检测]智慧交通铁路异物入侵检测数据集VOC+YOLO格式802张7类别](https://i-blog.csdnimg.cn/direct/70cd1bbd9ac44ba4aa0ae2a43db87c3d.png)